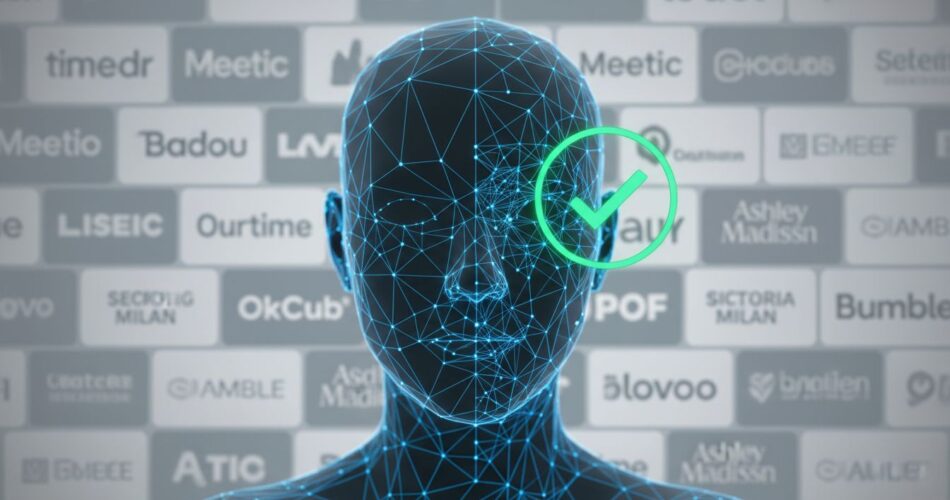

La verificación facial e IA en apps para ligar se ha convertido en una respuesta tecnológica a una amenaza real: cuentas falsas, estafas románticas y deepfakes que facilitan fraudes económicos y daños personales. Ante el aumento de reportes y pérdidas, muchas plataformas han empezado a exigir verificaciones biométricas durante el registro o en momentos clave de la interacción entre usuarios.

Este artículo explora cómo funcionan estas soluciones , desde el liveness en 3D y motores como FaceTec hasta el almacenamiento de «face vectors» cifrados, , qué tan efectivas son según datos públicos, y cuáles son los riesgos legales y de privacidad que plantean. También repasamos las técnicas de deepfake que impulsan las estafas y las mejores prácticas que combinan verificación, detección multimodal y educación del usuario.

Por qué las apps implementan verificación facial

Las cifras del FBI/IC3 muestran que en 2024 hubo 859,532 quejas relacionadas con crímenes por internet y pérdidas por aproximadamente $16.6 mil millones, con las estafas románticas y el criptofraude entre los vectores más costosos. Estos datos explican en gran medida por qué plataformas de citas apuestan por controles biométricos: reducir el número de cuentas falsas y proteger a usuarios vulnerables.

Match Group, propietario de Tinder, ha promovido Face Check como una medida que en mercados piloto redujo la exposición a «bad actors» en alrededor del 60% y los reportes de cuentas sospechosas en ~40%. Spencer Rascoff ha señalado públicamente que estas métricas respaldan la expansión de la verificación en EE. UU.: «Face Check ha reducido la exposición a bad actors en nuestros mercados piloto», declaró Rascoff.

Además, estudios de comportamiento muestran la demanda de mayor confianza: benchmarks UX (MeasuringU, 2024) reportan que ~36% de usuarios conocieron a alguien que se veía distinto en persona y 19% fueron solicitados para enviar dinero durante el uso de la app. Ese tipo de experiencias alimenta la presión para introducir verificaciones más robustas.

Cómo funciona la tecnología: liveness, FaceTec y almacenamiento

La verificación facial usada por Tinder/Match Group , con el motor biométrico suministrado por FaceTec, combina video selfie con detección de liveness en 3D para confirmar que la persona es real y está presente en el momento de la captura. El proceso consiste en un desafío de movimiento o respuesta a estímulos para impedir el uso de fotografías estáticas.

Match afirma que los vídeos usados para la comprobación se eliminan tras la revisión, y que lo que conservan son mapas faciales o «face vectors» cifrados y no reversibles mientras exista la cuenta. Esa arquitectura busca minimizar la retención de datos sensibles pero no elimina por completo preocupaciones sobre cuánto tiempo y en qué condiciones se guardan plantillas biométricas.

En la industria existe un modelo extendido: integraciones SDK + liveness + matching. Proveedores como Yoti, Veriff, Truepic y FaceTec ofrecen SDKs que aplicaciones (por ejemplo Jigsaw o PURE) integran para verificación de identidad, edad y liveness. Cada proveedor tiene políticas distintas de retención y borrado, lo que complica la gobernanza de datos en un ecosistema con múltiples actores.

Efectividad, métricas y contexto del fraude

Los datos iniciales de plataformas indican reducciones importantes en alcance de cuentas falsas; Match Group reporta aproximadamente 60% menos exposición a «bad actors» y ~40% menos reportes de cuentas sospechosas tras implantar Face Check. Estas cifras son prometedoras, pero deben leerse junto a observaciones del sector y la evolución del fraude.

El informe anual del FBI/IC3 2024 ayuda a poner esos números en contexto: millones de quejas y miles de millones en pérdidas sugieren que las verificaciones por sí solas no bastan , pero sí son una barrera adicional frente a bots y perfiles automatizados. Por otro lado, Chainalysis y otros informes del 2024/2025 documentan el auge de estafas «pig butchering» o romance‑crypto, con crecimientos de ingresos del orden del ~40% en algunos análisis, lo que demuestra la sofisticación y el impacto financiero de estas redes.

Expertos como Yoel Roth han subrayado que la verificación biométrica es una herramienta necesaria, aunque no suficiente: «La verificación ayuda a reducir malos actores, pero debe combinarse con detección en tiempo real y políticas claras de privacidad», afirmó Roth en declaraciones públicas sobre las iniciativas de seguridad de las plataformas.

Deepfakes, herramientas y el desafío técnico

Las herramientas de deepfake han avanzado rápidamente y se han vuelto más accesibles. Reportajes como el de WIRED (diciembre 2025) documentan plataformas de face‑swap en tiempo real , por ejemplo, Haotian, empleadas por redes de estafa para fabricar videochats y llamadas falsas. En esa investigación un especialista resumió su potencia con la frase: «Its results are nearly perfect.»

Ese nivel de realismo complica la detección automática: los estafadores usan face‑swap, voice cloning y actores remotos para sostener historias durante semanas o meses, y los canales cripto facilitan el blanqueo de fondos. Investigadores como Leyla Bilge (Norton) advierten que «la IA está cambiando el juego» y que las defensas deben evolucionar con rapidez.

La investigación académica intenta ponerse al día: papers recientes (PITCH 2024, SocialDF 2025) y trabajos emergentes como VerLM (enero 2026) exploran enfoques multimodales y basados en visión‑lenguaje para explicar decisiones y detectar deepfakes. También se proponen sistemas challenge‑response y análisis contextual que combinan señales textuales, temporales y biométricas para aumentar la robustez frente a ataques avanzados.

Riesgos legales, privacidad y demandas

El uso de biometría en apps de citas ha generado litigios significativos. En EE. UU. hay demandas que alegan recolección y escaneo de geometría facial sin el consentimiento adecuado; además, Bumble/Badoo acordaron un settlement por BIPA (Illinois) de $40M y se comprometieron a borrar datos biométricos recogidos. Estas acciones muestran el riesgo regulatorio y económico de gestionar mal datos biométricos.

Match Group afrontó sanciones regulatorias por prácticas de suscripción y cancelación: en 2025 acordó pagar $14M y cambiar prácticas con la FTC. Al mismo tiempo, leyes estatales como BIPA y marcos de privacidad tipo CPRA/GDPR clasifican datos biométricos y de salud o sexualidad como sensibles, ampliando las obligaciones de consentimiento informado y de minimización del dato.

Además, las políticas de retención varían según proveedores: por ejemplo, Veriff puede retener selfies/ID por 90 días en su entorno en vivo y archivar datos hasta 3 años según su política; mientras Match/Tinder declara que borra vídeos tras la revisión y conserva mapas cifrados durante la vida de la cuenta. Esa heterogeneidad exige transparencia para que el usuario comprenda riesgos y derechos.

Alternativas, mitigaciones y buenas prácticas

La industria tiende a combinar medidas: verificación en el onboarding, detección multimodal en el feed/mensajería, el bloqueo automático de señales de fraude, y educación a usuarios sobre señales de estafa. Proveedores técnicos (Truepic, Yoti, FaceTec) y soluciones de detección trabajan de la mano con políticas de producto para crear flujos menos invasivos y más explicables.

También hay prácticas concretas recomendadas: minimizar la retención de plantillas biométricas, usar cifrado y técnicas no revertibles para almacenamiento, transparencia sobre terceros que procesan datos, y ofrecer rutas claras de apelación y borrado. A nivel técnico, challenge‑responses y verificaciones periódicas incrementan la dificultad para operadores de estafas.

Finalmente, combinar verificación biométrica con señales sociales y comportamiento (por ejemplo, limitaciones en enlaces a pagos, revisiones humanas en reportes complejos y colaboración con fuerzas del orden) permite una defensa más holística. El objetivo es reducir daños reales , incluidos casos extremos como secuestros o agresiones relacionados con catfishing, manteniendo el respeto a la privacidad y al marco legal.

En resumen, la verificación facial y la IA en apps para ligar ofrecen beneficios medibles para reducir cuentas falsas y abusos, como han mostrado los pilotos de Match/Tinder, pero no eliminan todos los riesgos. La tecnología debe implementarse junto a políticas de privacidad robustas, transparencia y medidas antimala fe complementarias.

Los usuarios, legisladores y empresas deben seguir un diálogo informado: aplicar controles técnicos eficaces y transparentes, actualizar marcos regulatorios para datos biométricos, y educar a las personas sobre señales de fraude , porque la seguridad en línea es un esfuerzo compartido.